키워드

1. 목표 기반 환경에서 경험 재플레이를 개선하여 학습 효율성을 높임. 실패한 경험에서도 유의미한 학습이 가능하도록 설정하여 성능을 향상시킴.

2. "Hindsight Experience Replay"

3. Hindsight Experience Replay, sparse and binary reward, shaped reward

Reward Engineering

Reinforcement Learning의 다양한 분야에서 일반적으로 당면한 과제를 해결하는 것 뿐만 아니라, 최적의 policy를 학습하도록 유도하기 위해 reward function을 신중하게 설계한다. 다만 이러한 엔지니어링은 강화 학습 지식과 도메인 지식이 모두 필요하기 때문에 현실 세계에서 적용 가능성을 제한한다.

또한 희소(sparse)한 보상을 처리하는 것도 강화 학습의 가장 큰 과제 중 하나이다. 이에 희박하고 binary한 보상으로 샘플 효율적인 학습을 통한, 복잡한 보상 엔지니어링이 필요하지 않은 HER(Hindsight Experience Replay)라는 새로운 기술을 고안했다. 이는 문제에 대해 완료 여부만 나타내는 binary reward를 사용한 방식이이며, 로봇 팔로 물체를 조작하는 작업에 대한 실험으로 성능을 평가했다.

인간이 가지고 있는 능력 중 하나는 바람직하지 않은 결과로 원하는 결과만큼 많은 것을 배우는 것이다. 예를 들어, 하키를 배울때 퍽을 네트에 정확히 쏘려고 연습하는 상황을 가정하자. 퍽을 쳤으나 빗나간 경우에, 원하는 결과는 아니지만 결과를 얻기 위한 경험을 얻는다. 하지만 표준 RL 알고리즘은 수행된 일련의 작업이 성공적인 샷으로 이어지지 않았기 때문에, 매우 적은 경험치 혹은 아무것도 배우지 못했을 것이다. 심지어 또 다른 결론은 네트가 더 오른쪽에 배치되었다면 작업은 성공했을 것이라는 상황을 학습한다.

HER는 이러한 종류의 추론을 정확하게 수행할 수 있게 하고 off-policy RL 알고리즘과 결합할 수 있는 구조다. 또한 여러개의 달성할 수 있는 목표를 적용할 수 있다. 이는 샘플 효율성을 향상시킬 뿐만 아니라, 보상 signal이 희소하고 binary한 경우에도 학습을 가능한다. 현재 state 뿐만 아니라 goal state도 입력으로 사용하는 training universal policies으로, 에이전트가 달성하려고 했던 목표와 다른 목표로 각 에피소드를 replay 할 수 있다.

Reinforcement Learning

강화학습에서 환경은 state 집합 S, action 집합 A, 초기 state 분포 p(s0), reward function r, transition 확률 p(st+1|st, at), discount factor γ로 설명된다. 이를 바탕으로 에이전트의 목표는 기대 reward를 극대화하는 것이며, 이는 Q function 혹은 action-value function으로 정의된다. Optimal Q-function은 Q*로 표현되며 이는 Bellman equation을 따른다.

Deep Q-Network(DQN)는 discrete action space를 위한 model-free RL 알고리즘이다. DQN에서는 neural network를 통해 Q를 근사한다. 그리고 replay buffer에 transition tuple (st, at, rt, st+1)을 저장하고, 이후 해당 buffer에서 샘플링하여 minibatch SGD를 통해 NN을 학습한다. 이 과정에서 optimization을 안정화하기 위해 별도의 target network를 활용하며, 근사된 Q-함수를 Bellman equation에 만족시키기 위한 손실 함수를 사용한다.

Deep Deterministic Policy Gradients(DDPG)는 continuous action space를 위한 model-free RL 알고리즘이다. 이는 Target Policy(Actor) π와 action-value function approximator(Critic) Q 두 가지 neural network로 구성된다. Critic의 임무는 actor의 action-value function을 근사화하는 것이다. 에피소드는 target policy의 noisy 버전인 behavior policy로 생성된다. Critic은 DQN의 Q function과 유사한 방식으로 훈련되지만 target yt는 actor가 출력한 action을 사용하여 계산된다. Actor는 Q에 대한 손실로 훈련된다.

UVFA(Universal Value Function Approximator)는 달성하려고 시도할 수 있는 하나 이상의 목표가 있는 설정에 대한 DQN의 확장이다. 모든 에피소드는 분포 p(s0, g)에서 state-goal 쌍을 샘플링하는 것으로 시작한다. Goal은 전체 에피소드 동안 고정되어 있으며, 모든 단계에서 에이전트는 현재 state뿐만 아니라 현재 goal을 입력으로 받고 보상 rt = rg(st, at)을 얻는다. 이를 통해, Q function은 이제 state-action 쌍뿐만 아니라 goal에도 영향을 받는다. 이를 통해 Bellman equation에 직접 bootstrapping을 사용하여 Q function의 근사치를 훈련하는 것이 가능하다.

Hindsight Experience Replay

Motivation

HER의 필요성을 간단한 toy 환경을 구성하여 확인하고자 한다. 이 환경은 state space S = {0, 1}^n과 action space A = {0, 1,… . . , n − 1}으로 이루어져 있으며, 일부 정수 n에 대해 i번째 작업을 실행하면 상태의 i번째 비트가 반전된다. 모든 에피소드에 대해 우리는 초기 state와 목표 state를 uniform 샘플링하고 policy는 목표 state에 있지 않으면 -1의 보상을 얻는다.

n > 40에서 기존 RL 알고리즘은 이 환경에서 실패할 수밖에 없다. 그 이유는 -1 이외에 다른 보상을 결코 경험하지 못하기 때문이다. 이는 문제는 방문하는 state의 다양성이 부족한 것이 아니라, 큰 state space를 탐색하는 것이 불가능하기 때문이다. 이러한 문제를 해결하기 위해 더 많은 정보를 제공하고 에이전트를 목표로 유도하는 구조화된 shaped reward를 사용할 수 있다. 하지만 이 보상을 사용하면 toy 환경의 문제는 해결되지만 더 복잡한 문제에는 적용하기 어렵다. 이에 도메인 지식이 필요하지 않은 새로운 솔루션을 고려하게 되었다.

s1, … , sT의 에피소드에서 goal과 전부 다르다면, 에이전트는 매 step마다 -1의 보상을 받는다. 이를 활용한 핵심 아이디어는 trajectory를 다른 goal로 재검토하는 것이다. 이 trajectory는 state g를 달성하는 방법을 배우는 데 도움이 되지 않을 수도 있지만, state sT를 달성하는 방법에 대해서는 확실히 도움이 된다. 이렇게 g가 sT로 변경된 정보는 off-policy RL 알고리즘과 experience replay를 통해 얻을 수 있다. 뿐만 아니라 replay buffer에 남아있는 원래 goal g 또한 계속 replay할 수 있다. 이를 통해 replay된 trajectory의 최소 절반은 -1과 다른 보상이 포함되어 있어 학습이 훨씬 간단해지며, Deep NN과 같은 강력한 function approximator와 결합하면 에이전트는 훈련 중에 goal g를 관찰한 적이 없더라도 이를 달성하는 방법을 학습한다.

Multi Goal RL

Universal Value Function Approximators의 접근 방식을 바탕으로, 다양한 목표를 달성하도록 에이전트를 학습하고자 한다. 이는 state s ∈ S 뿐만 아니라 goal g ∈ G도 입력으로 사용하여 policy 및 value를 학습한다. 이렇게 multi-task를 수행하는 에이전트는 single-task만 수행하는 에이전트보다 더 쉽게 학습되면, 성능 측면에서도 더 좋다.

일반적인 policy는 RL 알고리즘을 사용하여 일부 distribution에서 goal과 초기 state를 샘플링하고, 일정 횟수의 time step에 대해 에이전트를 실행한 뒤, goal에 달성되지 않은 모든 time step에 부정적인 reward을 제공하여 훈련된다. 이 reward function은 sparse하고 유익하지 않기 때문에 실제로는 잘 작동하지 않는다. HER는 이러한 문제를 해결한다.

Algorithm

HER의 구현은 매우 간단하다. Replay buffer에 에피소드에 사용된 원래 goal 뿐만 아니라 다른 goal로 구성된 tuple을 함께 st → st+1 transition마다 저장한다. 추구되는 goal은 에이전트의 행동에 영향을 주지만 환경에는 영향을 미치지 않으므로, off-policy RL 알고리즘을 사용한다고 가정하면 임의의 goal로 trajectory를 replay 할 수 있다.

HER를 사용하기 위해 선택해야 하는 한 가지 선택은 replay에 사용되는 goal을 선정하는 것이다. 가장 간단한 버전은 최종 state에서 달성되는 goal를 사용하는 것이다. 즉 각 transition을 replay buffer에 두 번 저장하며, 한 번은 에피소드 생성에 사용된 goal, 다른 한 번은 사용하기로 선정한 goal을 바탕으로 저장한다. 이를 바탕으로 극도로 희박한 보상으로 학습이 가능할 뿐만 아니라, shaped reward보다 희박한 보상으로 더 나은 성능을 발휘한다.

결과

Environment

HER를 평가하기 위해 하드웨어 로봇을 기반으로 한 control 환경을 사용하였다. 이를 위해 손가락 두 개의 평행 그리퍼가 있는 7-DOF의 로봇 팔을 사용하였으며, 아래 3가지 다른 task를 고려했다.

- Push : 로봇 앞 테이블에 상자를 놓고 특정 위치로 상자를 옮기는 작업을 수행한다. 단 움켜쥐는 것을 방지하기 손가락은 잠겨 있다.

- Sliding : 퍽을 특정 위치까지 미끄러지게 미는 작업을 수행한다. 퍽을 치는 힘과 마찰을 통해 적절한 위치에 멈춰야 한다.

- Pick and Place : 밀기와 비슷하지만 목표 위치가 공중에 있고, 손가락이 고정되어 있지 않다.

이 작업들에 대한 보상으로 목표한 지점에 도착했는지 여부를 사용하여, binary하고 sparse한 reward를 제공한다. Action space는 4차원으로 구성된다. 3개의 차원은 다음 state에서 그리퍼 상대적 위치를 지정하며, 마지막 두 손가락 사이의 원하는 거리를 지정한다.

Multi-Goal vs Single-Goal

DDPG를 바탕으로, multi-goal 알고리즘에서 비교한 결과다. HER를 사용하지 않은 DDPG는 어떤 작업도 해결할 수 없으며, count-based exploration DDPG는 sliding에서만 약간의 진전이 있다. 반면, HER을 사용한 DDPG는 모든 작업을 거의 완벽하게 해결한다. 이는 HER가 binary하고 sparse한 보상을 통해 학습을 가능하게 한다는 것을 의미한다.

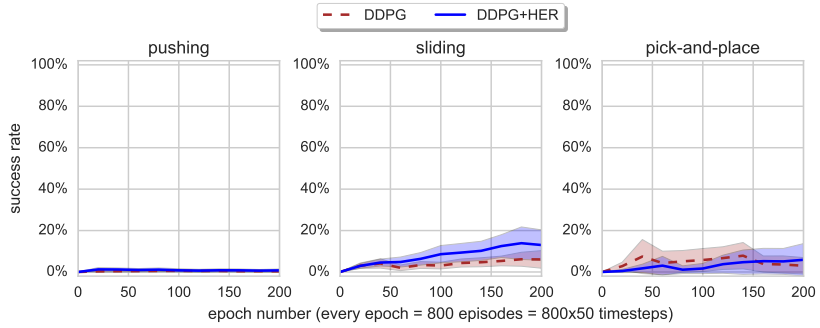

위 결과는 multi-goal이 아닌 single-goal를 사용할때 HER의 성능을 평가한 결과다. 모든 에피소드에서 DDPG + HER가 순수 DDPG보다 훨씬 더 나은 성능을 발휘한다는 것을 알 수 있다. 하지만 바로 위에서 확인한 multi-goal 결과와 비교하면 학습 속도가 상대적으로 느려졌음을 알 수 있다. 이를 통해 단일 목표에만 관심이 있더라도 여러 목표에 대해 훈련하는 것이 더 좋다는 것을 알 수 있다.

위 이미지는 현실 세계에서 평가한 사진이다. 상자 위치는 카메라를 통해 입력 받아 별도로 훈련된 CNN을 통해 입력으로 활용되었다. 처음에는 5번의 시도 중 2번의 시도에서 성공하였으나, 관측값에 가우스 노이즈(std=1cm)를 추가하여 policy를 재훈련하면 성공률이 5/5로 증가하였다.

Shape Reward

지금까지 binary 형식의 보상만 고려하였는데, 이에 shaped reward로 대체될 경우 성능이 어떻게 변하는지 확인하였다. DDPG나 DDPG + HER 모두 작업을 성공적으로 해결할 수 없었다. 그 이유는 최적화하는 것(shaped reward)과 성공 조건(목표 지점의 일정 반경 내에 도달하기) 사이에 불일치가 크기 때문이다. 또 다른 이유는 shaped reward가 exploration을 위한 잘못된 행동을 제한하기 때문이다. 이는 에이전트가 상자를 정확하게 조작할 수 없는 경우, 상자를 전혀 건드리지 않는 방법을 배우게 하기도 한다. 이를 통해 sparse한 binary reward를 통해 학습하는 것이 중요하다는 것을 시사한다.

Replay Strategy

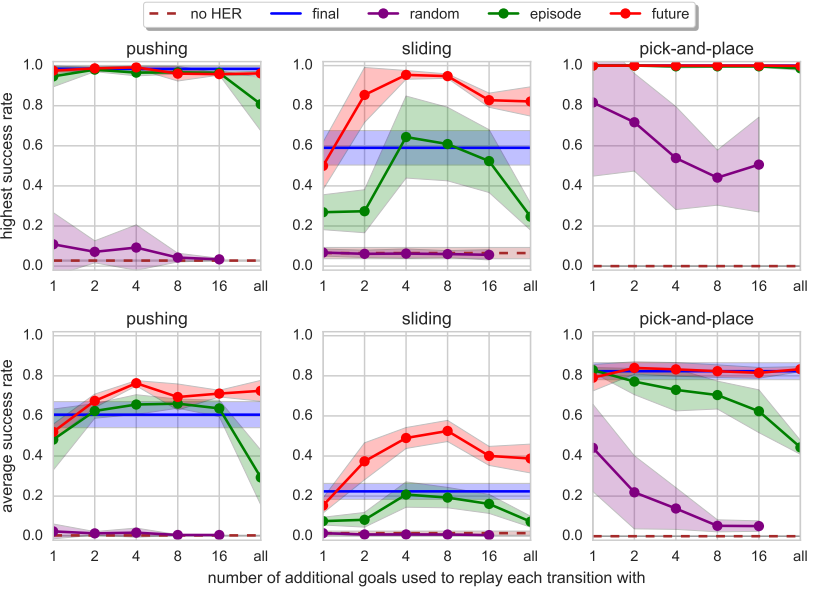

최종 state의 goal을 사용하는 것이 ‘final’에 해당하며, 그 외에도 다음과 같은 방식을 고려했다.

- Future : 재생되는 전환과 동일한 에피소드에서 발생하고 그 이후에 관찰된 k개의 무작위 상태로 재생합니다.

- Episode : 재생 중인 전환과 동일한 에피소드에서 나오는 k개의 무작위 상태로 재생합니다.

- Random : 전체 훈련 절차에서 지금까지 발생한 k개의 무작위 상태를 재생합니다.

하이퍼파라미터 k는 replay buffer에서 일반적인 experience와 HER experience의 비율을 제어한다. Random을 제외한 모든 방식이 k 값에 관계없이 문제를 거의 완벽하게 해결한다. k가 4 or 8인 future 방식은 가장 좋은 결과를 보이며, sliding을 유일하게 거의 완벽하게 해결한다. Future 방식의 k = 4에 대한 학습 곡선이 이전 ‘DDPG + HER (version from Sec 4.5)’ 에 해당한다. 이는 replay를 위한 가장 가치 있는 목표가 가까운 미래에 달성될 목표임을 확인시켜준다. 다만 k를 8보다 높게 늘리면 버퍼의 일반적인 replay 데이터 비율이 매우 낮아지므로 성능이 저하된다.

Reference

논문 링크 : https://arxiv.org/abs/1707.01495

'딥러닝 > Reinforcement Learning' 카테고리의 다른 글

| [RL] Large-scale Curiosity-driven Learning (0) | 2025.01.15 |

|---|---|

| [RL] SAC (Soft Actor-Critic) (0) | 2025.01.08 |

| [RL] ICM (Intrinsic Curiosity Module) (0) | 2024.12.25 |

| [RL] PPO (0) | 2024.12.18 |

| [RL] ACER (1) | 2024.12.11 |